字節(jié)視頻生成模型 PixelDance上線即夢(mèng)AI,用戶可免費(fèi)體驗(yàn)觀點(diǎn)

11月15日,字節(jié)跳動(dòng)視頻生成模型 PixelDance和Seaweed在即夢(mèng)AI正式上線,面向公眾免費(fèi)開(kāi)放使用。

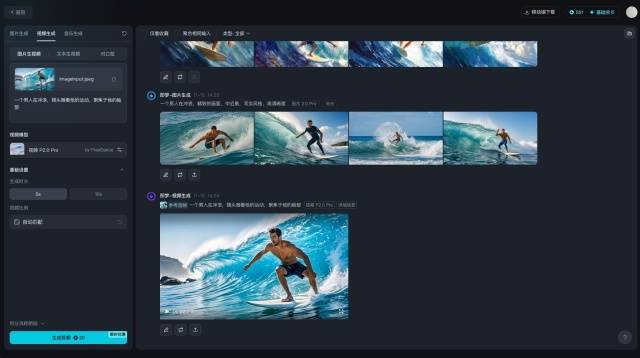

11月15日,字節(jié)跳動(dòng)視頻生成模型 PixelDance和Seaweed在即夢(mèng)AI正式上線,面向公眾免費(fèi)開(kāi)放使用。用戶進(jìn)入即夢(mèng)AI的“視頻生成”界面,在視頻模型里選擇“視頻P2.0 Pro”或“視頻S2.0 Pro”,即可分別體驗(yàn)這兩款模型,目前網(wǎng)頁(yè)版和手機(jī)端APP均已支持。

圖說(shuō):即夢(mèng)AI網(wǎng)頁(yè)版模型使用界面

字節(jié)跳動(dòng)兩款視頻生成模型于9月底首次發(fā)布,并通過(guò)即夢(mèng)AI、火山引擎分別面向創(chuàng)作者和企業(yè)客戶小范圍邀測(cè)。

據(jù)內(nèi)測(cè)創(chuàng)作者介紹,當(dāng)PixelDance生成10秒視頻時(shí),切換鏡頭3-5次的效果最佳,場(chǎng)景和角色能保持很好的一致性。通過(guò)小幅度、漸進(jìn)式的提示詞描述,PixelDance能生成魔術(shù)般的特效。此外,用戶還可使用時(shí)序提示詞、長(zhǎng)鏡頭等技巧,增強(qiáng)視頻的復(fù)雜度和表現(xiàn)力,對(duì)劇情創(chuàng)作非常友好。

Seaweed模型則在圖生視頻場(chǎng)景體現(xiàn)出較好的首幀一致性,可以保持與用戶輸入圖的一致性、色彩等細(xì)節(jié)還原,實(shí)現(xiàn)大幅度運(yùn)動(dòng)畫(huà)面流暢自然,具有視覺(jué)美感和真實(shí)感。

經(jīng)過(guò)剪映、即夢(mèng)AI等業(yè)務(wù)場(chǎng)景打磨和持續(xù)迭代,兩款模型可以更好地服務(wù)于專業(yè)創(chuàng)作者和藝術(shù)家們,應(yīng)用于設(shè)計(jì)、影視、動(dòng)畫(huà)等內(nèi)容場(chǎng)景,助力想象力的實(shí)現(xiàn)和故事創(chuàng)作。目前,即夢(mèng)AI為用戶提供每日積分贈(zèng)送,用戶可憑積分免費(fèi)體驗(yàn)兩款模型。

即夢(mèng)AI是字節(jié)跳動(dòng)旗下的AI內(nèi)容平臺(tái),支持通過(guò)自然語(yǔ)言及圖片輸入,生成高質(zhì)量的圖像及視頻。平臺(tái)提供智能畫(huà)布、故事創(chuàng)作模式,以及首尾幀、對(duì)口型、運(yùn)鏡控制、速度控制等AI編輯能力,并有海量影像靈感及興趣社區(qū),一站式提供用戶創(chuàng)意靈感、流暢工作流、社區(qū)交互等資源,為用戶的創(chuàng)作提效。

1.TMT觀察網(wǎng)遵循行業(yè)規(guī)范,任何轉(zhuǎn)載的稿件都會(huì)明確標(biāo)注作者和來(lái)源;

2.TMT觀察網(wǎng)的原創(chuàng)文章,請(qǐng)轉(zhuǎn)載時(shí)務(wù)必注明文章作者和"來(lái)源:TMT觀察網(wǎng)",不尊重原創(chuàng)的行為T(mén)MT觀察網(wǎng)或?qū)⒆肪控?zé)任;

3.作者投稿可能會(huì)經(jīng)TMT觀察網(wǎng)編輯修改或補(bǔ)充。